X-Robots-Tag — это специальный HTTP-заголовок, который позволяет вебмастерам управлять индексацией и обработкой веб-страниц поисковыми системами. Он является частью протокола Robots Exclusion Protocol и предоставляет больше возможностей по сравнению с традиционным мета-тегом robots, который размещается непосредственно в HTML-коде страницы. Основное преимущество X-Robots-Tag заключается в том, что он может применяться к различным типам контента, включая изображения, PDF-файлы и другие не HTML-документы.

X-Robots-Tag передается сервером в заголовках HTTP, когда браузер или поисковый бот делает запрос на страницу. Этот заголовок указывает, как поисковые системы должны обрабатывать содержимое. Например, можно запретить индексацию страницы, позволив при этом ее кэширование, или указать, что страница не должна отображаться в результатах поиска.

Примеры значений, которые могут быть указаны в X-Robots-Tag:

X-Robots-Tag: noindexX-Robots-Tag: noarchiveX-Robots-Tag: noindex, nofollowИспользование X-Robots-Tag — это мощный способ управления видимостью вашего контента в интернете. Это особенно полезно для сайтов с большим количеством контента, который не всегда должен быть доступен для индексации. Например, можно исключить страницы с дублирующимся контентом, страницы с конфиденциальной информацией или временные страницы, которые не предназначены для поисковых систем.

Кроме того, X-Robots-Tag упрощает управление индексацией для различных типов файлов, что делает его более гибким инструментом по сравнению с мета-тегами. Он особенно полезен для сайтов, которые используют много различных форматов файлов и хотят иметь полный контроль над тем, как эти файлы обрабатываются поисковыми системами.

Все эти три способа предназначены для того, чтобы давать поисковым системам указания по индексации вашего сайта. Но все же они различаются. Разберемся, в каких случаях предпочтительнее пользоваться тем или иным способом.

Стандартный и общепринятый метод управления индексацией сайта. Яндекс в основном четко понимает все указания, прописанные в файле и следует им. Но вот Google в этом плане более самостоятелен. Зачастую этот поисковик игнорирует указания файла robots.txt и в индекс попадают нежелательные страницы сайта. Использование этого способа очень удобно и просто, но не совсем надежно. Инструкции в файле robots.txt носят рекомендательный характер и могут игнорироваться поисковыми системами. Они управляют сканированием сайта, а не его индексацией.

Смысл данного метода тот же — дать указание поисковику об индексации контента. Тег прописывается между <head> и </head> в коде страницы сайта. Он может не только закрывать от индексации страницы, но и запрещать поисковым роботам переходить по внутренним и внешним ссылкам, сохранять документ в кэше.

Но у данного метода есть и недостатки: он не может регулировать взаимодействия поисковых систем с медиаконтентом. Ведь данный метатег невозможно прописать к картинке или в видео.

Наконец, третий способ управления поисковыми роботами, посещающими сайт — заголовок X-Robots-Tag. Данный метод считается самым надежным, так как его действие распространяется абсолютно на все виды контента, присутствующего на сайте.

Данный элемент устанавливается на уровне заголовков сервера, поэтому указания, прописанные в нем, имеют самые приоритетные правила.

Заголовок X-Robots-Tag использует те же самые директивы, что и метатег Meta Robots.

Рассмотрим основные из них, которые доступны в Google:

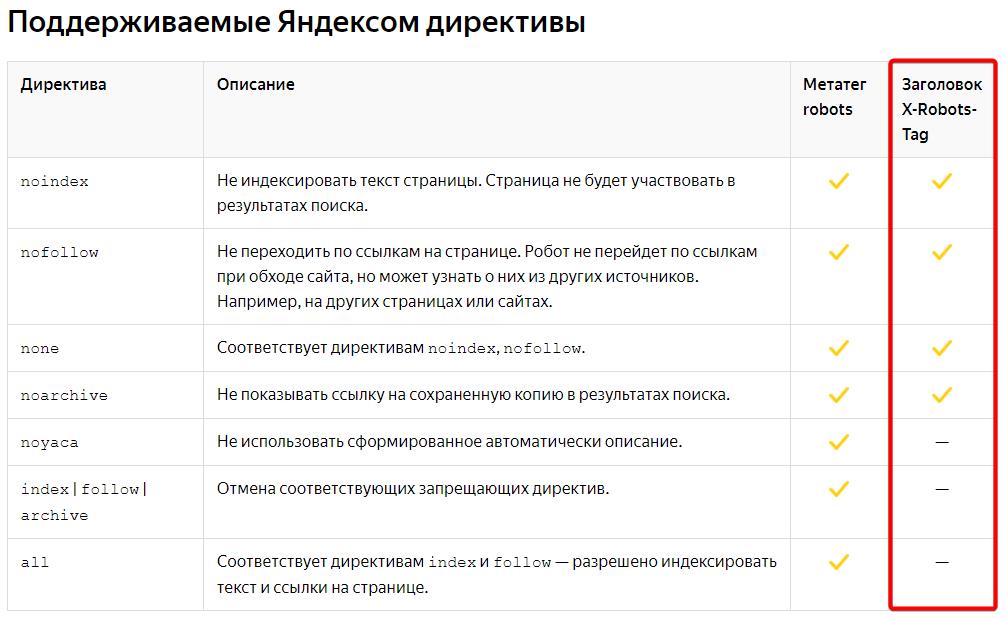

Яндекс для X-Robots-Tag понимает только noindex, nofollow, none, noarchive. Более подробно со всеми директивами Яндекса можно ознакомиться в справке Вебмастера.

Использовать заголовок X-Robots-Tag можно двумя способами:

Первый метод распространяется на статические документы, страницы и контент вашего сайта, а второй способ — на динамические страницы, создающиеся на вашем сайте в процессе его функционирования.

Чаще всего X-Robots-Tag используется с помощью файла .htaccess, поэтому разберем этот способ подробнее, а после кратко поговорим об использовании его с помощью PHP.

Данный файл .htaccess находится в корне сайта. Открывается для редактирования текстовым редактором или средствами, представленными в файловом менеджере вашего хостинга.

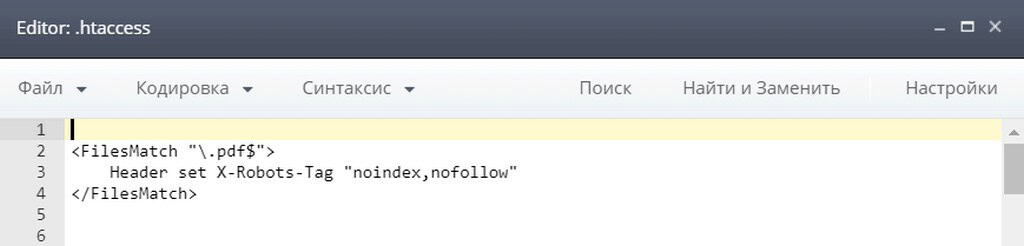

Допустим, вы решили закрыть от индексации все файлы .pdf, имеющиеся на вашем сайте. В .htaccess прописывается следующее:

<FilesMatch> — директива, позволяющая искать на сайте файлы, используя регулярные выражения.

В нашем случае, регулярным выражением является .pdf, а знак $, стоящий перед ним, указывает на то, что выражение находится в конце строки.

Таким образом, будут найдены все .pdf файлы и закрыты от индексации с помощью noindex. Также, директива nofollow запретит переходить по ссылкам в этих файлах.

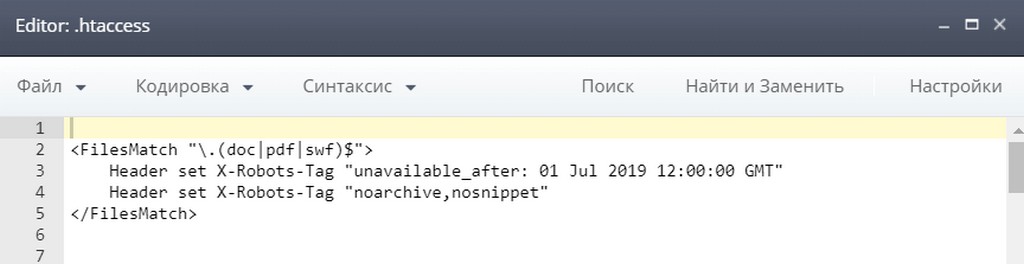

Еще пример:

Будут найдены все файлы .doc, .pdf и .swf. К ним будут применены следующие правила:

В данном случае нам понадобится файл index.php, который также находится в корне вашего сайта. Между тегами <head> и </head>, нужно прописать функцию header.

Например, чтобы запретить индексацию контента и переход по ссылкам, функция должна выглядеть так:

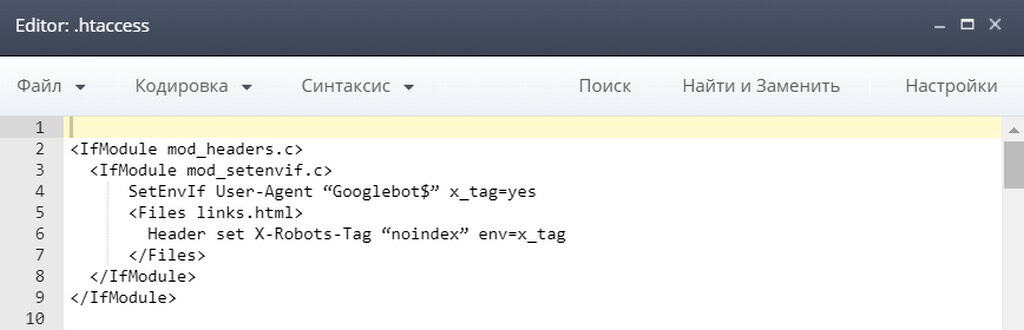

Иногда бывают ситуации, в которых необходимо скрыть настройки своего сайта от посторонних глаз. Давайте настроим наш X-Robots-Tag таким образом, чтобы его указания видели только роботы поисковых систем.

Опять редактируем файл .htaccess:

Теперь X-Robots-Tag будет виден только поисковому роботу Google.

Если вы проверяете у своего сайта, то соответственно лучшим способом — это будет заглянуть в файл .htaccess.

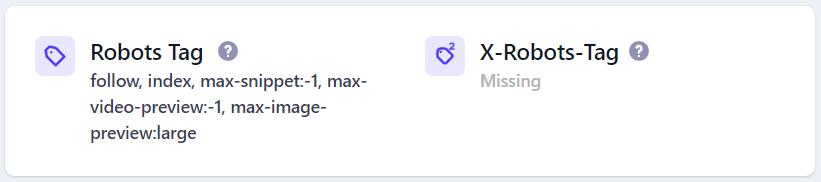

Если у вас нет доступа к этому файлу, то тогда могут помочь эти инструменты. Рассмотрим несколько способов проверки HTTP-заголовка X-Robots-Tag в программах, сервисах и с помощью плагинов к браузерам.

В сервисе Яндекса заголовок запрещающий индексацию страницы, будет выглядеть вот так.

Онлайн инструмент, простой и понятный в использовании.

Русский сервис для проверки x-robots-tag.

Сервис русскоязычной программы по сканированию сайтов. Плюсы, что можно проверять одновременно до 50 url.

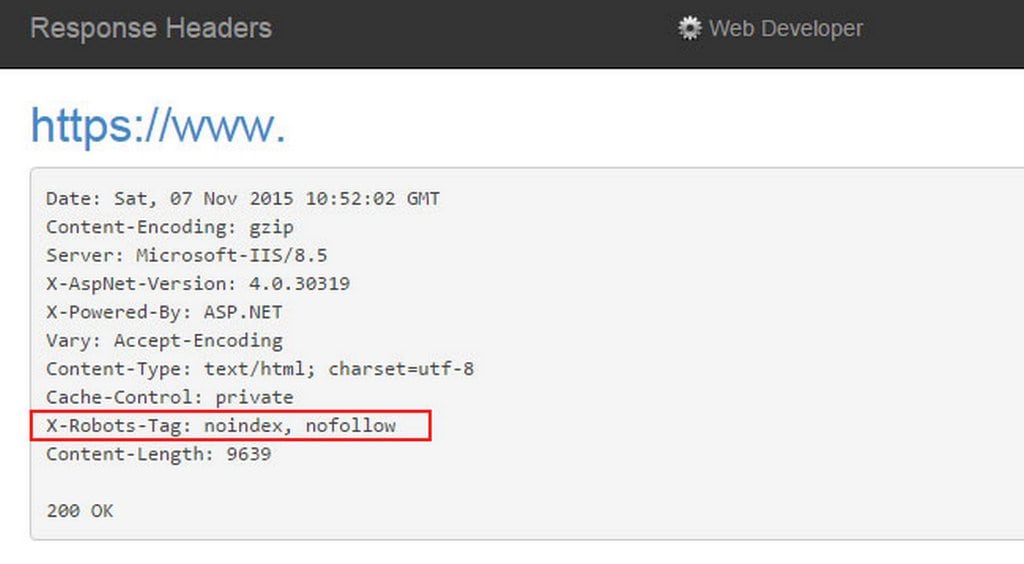

Установите расширение в ваш браузер, на интересующем вас документе нажмите на значок плагина и проследуйте: «Information» → «View Response Headers».

Результаты проверки выглядят так:

Позволяет просматривать ответ сервера прямо при просмотре страниц. Очень удобный плагин. Доступен для Google Chrome и Firefox.

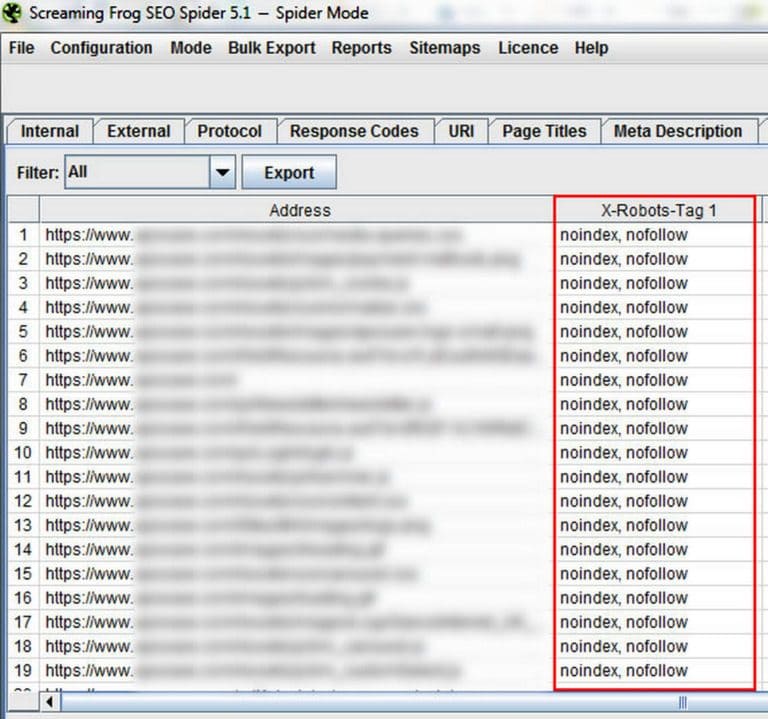

Данная программа позволяет сделать анализ всего сайта целиком, отдельных документов или отдельной директории. Закрытые для индексации документы будут отдельно выделены следующими параметрами:

Очень удобный инструмент для обхода огромных сайтов. Результаты выглядят так:

Русская разработка аналога Screaming Frog. Более современный интерфейс, стоит дешевле и справляется не хуже с большим объемом данных.

Использование X-Robots-Tag имеет ряд преимуществ:

Использование данного метода должно осуществляться с осторожностью и пониманием значений директив.